La IA no debe utilizarse para diagnósticos médicos, según una nueva investigación publicada en la revista PLOS One. El estudio, realizado por la Universidad de West London, encontró que, ante una serie de preguntas médicas, ChatGPT dio un diagnóstico correcto menos de la mitad de las veces.

Los investigadores le pidieron que eligiera el diagnóstico correcto entre una variedad de opciones, así como que proporcionara una explicación de su elección. Se descubrió que era correcto sólo el 49% de las veces, y al mismo tiempo demostró ser capaz de simplificar terminología médica compleja.

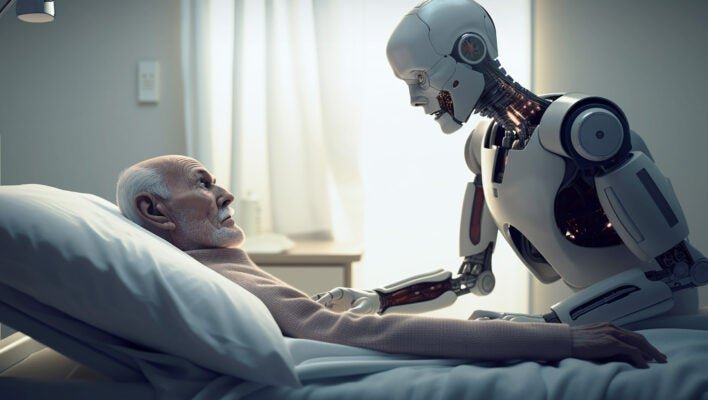

En medio de una oleada de actividad en el espacio de la atención médica, con investigadores deseosos de explorar posibles casos de uso para esta tecnología de rápido crecimiento, estos hallazgos sugieren que los robots no rondarán las salas de los hospitales en el corto plazo.

Los investigadores presentaron a ChatGPT 150 casos médicos complejos. Se solicitó a la plataforma que proporcionara el diagnóstico correcto en un formato de opción múltiple, junto con su justificación. El equipo observó que solo acertaba el 49% de las veces, aunque dio respuestas competentes y simplificadas que parecían convincentes.

Publicado en julio, el estudio se propuso evaluar la «precisión diagnóstica y la utilidad de ChatGPT en la educación médica», según CBC. El investigador principal, el Dr. Amrit Kirpalani, dijo: «Queríamos saber cómo se abordarían… esos casos complicados que vemos en la medicina».

Fuente: Tech.Co | Gus Mallett

Para leer más ingresa a: https://tech.co/news/chatgpt-medical-diagnosis-wrong